-

研究院优秀青年创业者交流座谈会成功召开 共话创新创业新未来

2025年6月20日,研究院成果转化中心主办的"优秀青年创业者交流座谈会"成功召开。本次活动汇聚了十余位研究院各孵化企业的优秀创业者代表,与来自南京创投集团、南京银行、江苏世纪同仁律师事务所的特邀专家,就"资本对接+金融赋能+法律护航"等话题进行了深度的分享与交流。

2025-07-25 -

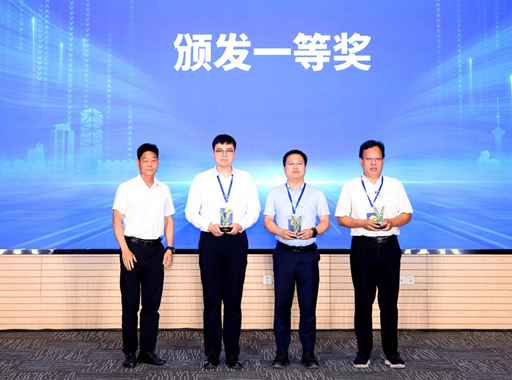

喜报 | 研究院两家孵化企业在第八届江苏省青年创新创业大赛中荣获一等奖

2025年6月5日,由中共南京市委人才工作领导小组办公室、南京市科技局联合主办的“科技镇长团杯”第八届江苏省青年创新创业大赛总决赛传来喜报:依托我院成果转化创新优势,中科洵瞳“机器人空间智能解决方案领跑者”项目与中科硅纪“Casia Hand通用类人灵巧操作具身智能机器人”项目,经过层层选拔,从全省众多优质参赛项目中脱颖而出,双双荣获总决赛一等奖。

2025-06-10 -

“灵巧手”突破具身智能瓶颈,“脑机接口”攻克疾病治疗难题

拿起一颗鸡蛋,既不会用力过大捏爆,也不会力道过轻掉落。这对人类来说是与生俱来的本领,对机器人来说一度是个大挑战。这一挑战,已经被中科硅纪研发的“灵巧手”(Casia Hand系列类人机器手及机器人整机)轻松完成。这里的仿人灵巧手不仅可以轻松将鸡蛋“拿捏”,还可以握住扳手拧螺丝、捏起滴管和烧杯做实验,拎起水果刀切火龙果。

2025-04-22 -

研究院承办的麒麟科创园成果转化项目融资对接会成功召开

2025年4月1日,由麒麟科创园主办、中科南京人工智能创新研究院承办的“麒麟科创园成果转化项目融资对接会”在南京成功举办。本次对接会聚焦人工智能、集成电路、星地通信领域颠覆性、高精尖技术项目,吸引了江苏省产业科技研究院、毅达资本、省高投、南创投等知名投资机构参会,共同探索科技成果转化与资本对接的新模式,推动创新链、产业链、资金链、服务链深度融合。

2025-04-03 -

喜报 ∣ 研究院引进企业南京图格医疗入选江苏省级专精特新中小企业、江苏潜在独角兽企业两项名单

近日,江苏省工信厅公示了全省2024年度省级专精特新中小企业,研究院引进企业——“南京图格医疗科技有限公司”(以下简称“南京图格医疗”)获得专精特新中小企业认定。在2024年度,南京图格医疗还入选了江苏潜在独角兽企业。

2025-01-10 -

-

深化电力AI规模化应用 打造电网行业新质生产力——新疆信息产业有限责任公司一行到访我院交流

10月15日至16日,新疆信息产业有限责任公司总经理彭钟,业务专家贾秉健、贾江、赵波等一行到访我院,就“深化电力AI规模化应用 打造电网行业新质生产力”进行了深入调研和技术交流。中科南京人工智能创新研究院副院长程健,研究院孵化企业中科方寸知微总经理冷聪、市场营销总监魏学备及相关技术专家参加。

2024-10-25 -

研究院承办的CCF决策智能会议暨RLChina 2024 大会在广州圆满召开

由中国计算机学会 (CCF)主办,中国计算机学会计算经济学专业组、中国计算机学会香港会员活动中心、香港科技大学(广州)、中科南京人工智能创新研究院共同承办的“CCF决策智能会议暨RLChina 2024”于10月12-18日在香港科技大学(广州)校园隆重举行。为期7天的盛会汇聚了90余位国内外专家学者以及约500名参会者共同探讨决策智能研究。

2024-10-23 -

研究院孵化项目荣获2024年“创青春”南京青年创新创业大赛一等奖

备受瞩目的2024年“创青春”南京青年创新创业大赛经过数月的激烈角逐圆满落下帷幕,中科南京人工智能创新研究院孵化项目“Casia Hand通用类人灵巧操作机器人”在六十多个决赛项目中脱颖而出,夺得排名第一,荣获一等奖。

2024-08-15 -